|

| |

|

|

|

|

Big data en santé |

|

|

| |

|

| |

Big data en santé

Sous titre

Des défis techniques, humains et éthiques à relever

Dans le domaine de la santé, le big data (ou données massives) correspond à l’ensemble des données socio-démographiques et de santé, disponibles auprès de différentes sources qui les collectent pour diverses raisons. L’exploitation de ces données présente de nombreux intérêts : identification de facteurs de risque de maladie, aide au diagnostic, au choix et au suivi de l’efficacité des traitements, pharmacovigilance, épidémiologie… Elle n’en soulève pas moins de nombreux défis techniques et humains, et pose autant de questions éthiques.

Dossier réalisé en collaboration avec Rodolphe Thiebaut, directeur de l’équipe Statistiques pour la médecine translationnelle (unité 1219 Inserm/Inria), enseignant à l'ISPED (Bordeaux), directeur de l’unité de soutien méthodologique à la recherche clinique et épidémiologique au CHU de Bordeaux et chercheur au Vaccine Research Institute (Créteil).

Comprendre l’importance du big data en santé

En santé comme dans bien d’autres domaines, les progrès technologiques ont fait exploser la quantité d’informations recueillies à chaque instant. Ainsi, si dix ans ont été nécessaires pour obtenir la première séquence d’un génome humain, en 2003, il faut aujourd’hui moins d’une journée pour parvenir au même résultat. Cette accélération technologique fait croître le volume de données disponibles de manière exponentielle. Une aubaine pour la recherche en santé pour qui le big data est une source presque inépuisable de nouvelles connaissances, indispensables à l’innovation et aux progrès médicaux !

Un nombre important de sources et de types de données

La France possède environ 260 bases de données publiques dans le domaine de la santé, et le portail Epidémiologie‐France recense jusqu’à 500 bases de données médico-économiques, cohortes, registres et études en cours.

Les bases de données médico-administratives

Ces bases offrent des données objectives et très exhaustives à l’échelle de larges populations, avec peu de personnes perdues de vue en cours de suivi. Des atouts majeurs par rapport aux informations qui peuvent être recueillies lors d’études, poursuivies à court ou moyen terme, menées dans des populations spécifiques ou en nombre limité, et souvent fondées sur les déclarations des participants.

La plus riche des bases médico-administratives est le SNIIRAM (Système national d’information interrégimes de l’Assurance maladie). Dans cette base sont enregistrés tous les remboursements effectués par l’Assurance maladie pour chaque cotisant, tout au long de leur vie (biologie, médicaments, ambulances, consultations avec dates et noms des professionnels de santé vus, codes du type de maladie dans certains cas…). Ce système permet le suivi à long terme de données fiables.

Il existe beaucoup d’autres bases médico-administratives, comme celle de l’ATIH (Agence technique de l'information sur l'hospitalisation) ou celles des caisses de retraite (dont la CNAV). Il existe également des bases gérées par des centres de recherche, notamment celle du CépiDc (Inserm) qui recense les causes médicales de décès en France depuis 1968.

Qui accède aux données du SNIIRAM ?

La base est actuellement accessible aux agences sanitaires et organismes publics de recherche à but non lucratif. En 2013, une cinquantaine de chercheurs l’a interrogée de manière régulière, réalisant plus de 17 000 requêtes, soit 30% de plus que l'année précédente.

Un arrêté du ministère de la Santé qui interdit l'accès à cette base aux organismes à but lucratif (compagnie d'assurances, laboratoire pharmaceutique…) a été jugé illégal par le Conseil d’État qui demande son annulation d’ici fin 2016. Par conséquent, toutes les structures voulant mener une étude d'intérêt général pourront bientôt accéder à ces données et les demandes devraient donc exploser dans les années à venir.

Les cohortes

Une cohorte est un groupe de personnes partageant un certain nombre de caractéristiques communes, que des chercheurs suivent pendant un temps plus ou moins long afin d’identifier la survenue d’événements de santé (maladie ou dysfonctionnement de l’organisme) et des facteurs de risque ou de protection s’y rapportant.

Les organismes de recherche montent de grandes cohortes, incluant jusqu’à plusieurs dizaines de milliers de personnes, suivies pendant plusieurs années. C’est le cas par exemple des cohortes Constances, I-Share ou encore MAVIE et NutiNet-Santé, mises en œuvre en partenariat avec l’Inserm. La cohorte Constances, en cours de constitution, inclura à terme 200 000 adultes de 18 à 69 ans consultant dans des centres d'examens de santé de la Sécurité sociale. La cohorte I-Share inclura 30 000 étudiants des universités, suivis pendant 10 ans. L’observatoire MAVIE étudie les accidents de la vie quotidienne chez plus de 25 000 volontaires internautes. Quant à NutiNet-Santé, elle récolte une multitude de données sur le mode de vie, la santé et les habitudes alimentaires de 500 000 Français.

Toutes ces données récoltées permettent des études et une surveillance épidémiologique, potentiellement à fort impact en santé publique.

Les études cliniques

Les laboratoires publics mènent par ailleurs de très nombreux travaux de recherche clinique, incluant des populations particulières de patients dont les profils de risque et les états de santé sont analysés. Or, le nombre de données collectées chez un même patient ne cesse de croitre, avec des centaines d’informations recueillies chez un même individu, contre une dizaine il y a quelques années.

En oncologie, des dizaines de paramètres cliniques, biologiques, d’imagerie et de génétique sont systématiquement recueillis. C’est aussi le cas pour le développement des vaccins. Ainsi, dans le cadre de l’essai clinique DALIA réalisé par Vaccine Research Institute, destiné à évaluer un vaccin thérapeutique contre le VIH, toutes les cellules immunitaires des patients ont été comptées grâce à la reconnaissance des marqueurs de surface, et leur fonctionnalité a été testée. Le protocole a généré environ 800 mesures par patient et par visite, sans compter l’étude de l’expression génétique de nombreux marqueurs (47 000 sondes/patient/visite) et du séquençage à haut débit du virus lui-même.

Les objets de santé connectés

Les objets de santé connectés génèrent également de très nombreuses données transmissibles et partageables : appareils mesurant le nombre de pas, la fréquence cardiaque, la glycémie

glycémie

Taux de glucose (sucre) dans le sang.

, la pression artérielle… Ces données sont le plus souvent stockées et gérées par des géants d’internet ou GAFAM : Google, Apple, Facebook, Amazon et Microsoft.

Les enjeux de la recherche

Des défis techniques majeurs

Les énormes volumes de données désormais disponibles soulèvent des défis techniques concernant leur stockage et les capacités d’exploitation. Des programmes et des algorithmes informatiques et statistiques de plus en plus complexes s’avèrent nécessaires.

Les organismes de recherche disposent tous de serveurs de stockage et de supercalculateurs. Dans la plupart des cas, compte tenu de leur coût, ces plateformes sont mutualisées. C’est par exemple le cas du Mésocentre de calcul intensif aquitain (MCIA, Bordeaux), partagé par les universités de Bordeaux et les laboratoires CNRS, Inra, Inria et Inserm de la région. Autre exemple à Lyon, avec Platine, une plateforme européenne d’immunomonitoring gérée par plusieurs entreprises de biotechnologie ainsi que le Centre Léon Bérard de lutte contre le cancer et l’Inserm. Elle vise à aider les médecins à la décision thérapeutique en cancérologie et en infectiologie, en permettant l’analyse du statut immunologique initial des patients.

Autre problématique, les données massives sont assez fragmentées. Les informations collectées sont en effet de plus en plus hétérogènes, de par :

* leur nature (génomiquegénomiqueÉtude conduite à l’échelle du génome, portant sur le fonctionnement de l’organisme, d’un organe, d’une pathologie...

, physiologique, biologique, clinique, sociale…),

* leur format (texte, valeurs numériques, signaux, images 2D et 3D, séquences génomiques…),

* leur dispersion au sein de plusieurs systèmes d'information (groupes hospitaliers, laboratoires de recherche, bases publiques…).

Pour rendre possible leur traitement et leur exploitation, ces informations complexes doivent être acquises de manière structurée, et codées avant de pouvoir être intégrées dans des bases ou des entrepôts de données. Des standards se développent, tel I2b2 (pour Informatics for Integrating Biology and the Bedside), développé à Boston et désormais utilisé au CHU de Rennes, à Bordeaux ou encore à l’Hôpital européen Georges Pompidou (Paris). Ce système a par exemple été utilisé́ pour identifier et quantifier le risque accru d’infarctus du myocarde chez les patients sous Avandia, et a contribué́ au retrait du marché́ de ce médicament.

Grâce à ces standards, les hôpitaux et les centres de soins sont mieux armés pour compiler toutes les données collectées (pharmacie, biologie, imagerie, génomique, médico-économique, clinique...) dans des entrepôts de données biomédicales, interrogeables par les chercheurs via des interfaces web. De nombreuses équipes de recherche travaillent également sur des plateformes intégrées, pour apparier des bases et agréger leurs données avec celles de cohortes. Ainsi, le projet Hygie, conduit par l’Institut de recherche et de documentation en économie de la santé, apparie les bases SNIIRAM et SNGC (Système national de gestion des carrières de l’Assurance retraite). L’objectif est de constituer un système d’information sur les indemnités journalières de sécurité́ sociale sur un échantillon de 800 000 personnes, qui servira à enrichir les fichiers de la cohorte CONSTANCES.

En pratique

Lorsqu’un chercheur souhaite démarrer une étude se fondant sur l’utilisation de données massives, il commence par identifier les bases qui lui sont utiles et demande un accès spécifique aux équipes ou organismes qui détiennent ces données. Il doit ensuite s’entourer de nombreuses compétences pour effectuer des méta-analyses

méta-analyses

Analyse statistique faite à partir de plusieurs études portant sur un même sujet.

intégrant toutes ces données. Pour l’essai DALIA par exemple, l’analyse des résultats a nécessité la contribution d’une cinquantaine de personnes issues de disciplines différentes : cliniciens, immunologistes, biologistes, virologistes, techniciens de laboratoire, assistants de recherche clinique, gestionnaires de bases de données, biostatisticiens ou encore bioinformaticiens.

Le big data, quelles utilités ?

Entreprises, organismes de recherche, à but lucratif ou non, scientifiques, médecins, industriels…. Le big data intéresse de très nombreux acteurs du monde de la santé car il permet de nombreux progrès médicaux.

Mieux prévenir et prendre en charge les maladies

Les données multidimensionnelles récoltées à long terme sur de larges populations, permettent d’identifier des facteurs de risque pour certaines maladies comme le cancer, le diabète, l’asthme ou encore les maladies neurodégénératives. Ces facteurs servent ensuite pour construire des messages de prévention, et mettre en place des programmes à destination des populations à risque.

Le big data permet en outre le développement de systèmes d’aide au diagnostic et d’outils permettant la personnalisation des traitements. Ces systèmes se fondent sur le traitement de grandes masses de données cliniques individuelles. Dans cette veine, le super-ordinateur Watson d’IBM permet par exemple d’analyser en quelques minutes le résultat du séquençage génomique de patients atteints de cancer, de comparer les données obtenues à celles déjà disponibles, et de proposer ainsi une stratégie thérapeutique personnalisée. En l’absence de cet outil, ce travail d’analyse prend plusieurs semaines. Les cliniques et hôpitaux intéressés passent un partenariat avec IBM qui détient ce super-ordinateur et fournit les résultats.

Le big data peut également permettre de vérifier l’efficacité d’un traitement. Par exemple, dans le domaine des vaccins, les cliniciens mesurent aujourd’hui des centaines de paramètres au cours des essais cliniques : comptages cellulaires, fonctionnalité cellulaire, expression de gènes d’intérêt... alors qu’il y a quelques années, on se limitait à la concentration des anticorps

anticorps

Protéine du système immunitaire, capable de reconnaître une autre molécule afin de faciliter son élimination.

d’intérêt. À terme, cette évolution, les données massives qu’elle génère et la capacité à les analyser, pourrait permettre de vérifier qu’une vaccination a bien fonctionné au bout d’une heure seulement, à partir d’une micro goutte de sang.

Prédire des épidémies

Disposer de nombreuses informations sur l’état de santé des individus dans une région donnée permet de repérer l’élévation de l’incidence de maladies ou de comportements à risque, et d’alerter les autorités sanitaires.

Ainsi, le site HealthMap a pour objectif de prédire la survenue d’épidémies à partir de données provenant de nombreuses sources. Développé par des épidémiologistes et des informaticiens américains en 2006, ce site fonctionne en collectant les notes de départements sanitaires et d’organismes publics, les rapports officiels, des données internet… Le tout est mis à jour en continu pour identifier des menaces sanitaires et alerter les populations. Citons aussi le simulateur GLEAM, destiné à prédire la dissémination d’une épidémie en particulier, en exploitant les données de transport aérien.

En France, depuis 1984, le réseau Sentinelles suit plusieurs maladies infectieuses et alerte sur les épidémies grâce à la contribution de 1 300 médecins généralistes et d’une centaine de pédiatres répartis sur tout le territoire. Ces derniers rapportent au moins une fois par semaine le nombre de cas observés pour sept maladies transmissibles (diarrhée aiguë, maladie de Lyme, oreillons, syndromes grippaux, urétrite masculine, varicelle et zona) ainsi que les actes suicidaires. Les données sont transmises, via un réseau sécurisé, auprès de l’institut Pierre Louis d’Épidémiologie et de Santé Publique France, en collaboration avec l'Institut de veille sanitaire (InVS).

Améliorer la pharmacovigilance

L’analyse des données issues de cohortes ou des bases médico-économiques sur le long terme peut donc permettre d’observer beaucoup de phénomènes, et notamment de faire des rapprochements entre des traitements et la survenue d’événements en santé. Cette pratique permet de repérer des événements indésirables graves et d’alerter sur certains risques. En 2013, la base de données du SNIIRAM avait ainsi permis d’étudier le risque d’AVC et d’infarctus du myocarde chez les femmes utilisant une pilule contraceptive de 3e génération.

Entre protection des données et avancée de la recherche : les défis éthiques du big data

Lors d’un essai clinique, un consentement est nécessaire avant le recueil de données de santé. De même, tout chercheur ou clinicien qui utilise des données du soin doit en informer le patient concerné et faire une déclaration auprès de la CNIL. Mais d’autres recueils se font à l’insu des contributeurs, notamment lors de recherches sur internet par mots clés ou lors de la transmission de données d’objets connectés. Cela pose évidemment des problèmes éthiques relatifs au souhait des citoyens de partager ou non ces données avec des tiers, ainsi que sur la préservation de l’anonymat.

Et de nombreuses autres questions se posent : faut-il conserver toutes les données ? Faut-il les mutualiser ? Qui doit les gérer et sous quelles conditions les partager ? Comment faire en sorte que Google, Apple, Facebook et Amazon ne s’approprient pas une partie d’entre elles ? Les enjeux sont de taille : risque de divulgation de la vie privée et conséquences pour la vie sociale, perte de confiance dans la puissance publique et la confidentialité de la recherche, harcèlement publicitaire... Ces problématiques font régulièrement l’objet d’avis de la part de comités d’éthiques, dont le Comité consultatif national d’éthique en France.

Les pouvoirs publics se sont également saisis de la question : la loi de modernisation de notre système de santé, promulguée le 26 janvier 2016, prévoit en effet l'ouverture des données agrégées de santé à des fins de recherche, d'étude ou d'évaluation d'intérêt public, à tout citoyen, professionnel de santé ou organisme (public ou privé) participant au fonctionnement du système de santé et aux soins. Cette ouverture est assortie de plusieurs conditions :

* les données ne doivent pas permettre l’identification des personnes concernées (la loi restreint drastiquement l’accès aux données à caractère personnel pouvant permettre l’identification d’une personne),

* les travaux ne doivent pas aboutir à la promotion de produits en direction des professionnels de santé ou d'établissements de santé, ni permettre l'exclusion de garanties des contrats d'assurance ou la modification de cotisations ou de primes d'assurance.

Pour y avoir accès, tout organisme de recherche ou d’étude désireux de mener un projet d’intérêt public doit soumettre ce dernier à l’Institut national des données de santé, composé entre autres de représentants de l'État, d'usagers de l'Assurance-maladie et de producteurs et d'utilisateurs publics et privés de données de santé. Le protocole de l’étude devra ensuite être validé par un comité scientifique, avant que la CNIL ne se prononce sur ses aspects relatifs au respect de la vie privée. Néanmoins, en juin 2016, les décrets d’application pour cette nouvelle organisation n’étaient toujours pas parus.

L’Inserm et le Système national des données de santé

La loi de modernisation du système de santé de janvier 2016 prévoit la création du Système national des données de santé (SNDS). Ce système sera notamment composé :

* des données de l'Assurance maladie (SNIIRAM),

* des données hospitalières (PMSI)

* des causes de décès (CépiDc-Inserm).

Il est prévu que la gouvernance de ce système inclue les producteurs de données, parmi lesquels l'Inserm. Plus concrètement, l’Inserm devrait jouer le rôle d’opérateur d’extraction et de mise à disposition des données pour des traitements mis en œuvre à des fins de recherche.

Marisol Touraine, ministre des Affaires sociales et de la Santé, a lancé en avril 2016 une consultation nationale en ligne sur le big data en santé. L’objectif est que chaque Français puisse donner son avis sur les objectifs souhaités pour les patients, les professionnels de santé, les industries, les assureurs ou la puissance publique, mais également sur les conditions dans lesquelles l’exploitation des données de santé est acceptable. Les conclusions sont attendues fin 2016. Les chercheurs plaident quant à eux pour une ouverture assez large des données, et un accès simplifié. Leur souhait est de parvenir à accélérer la recherche via des plateformes techniques adaptées, permettant de hauts niveaux de sécurité (ne collecter que des données ayant un intérêt potentiel pour le sujet de recherche, cloisonner les données identifiantes, chiffrer certaines informations, limiter les accès et la copie des informations...).

DOCUMENT inserm LIEN |

| |

|

| |

|

|

|

Ataxie de Friedreich : une thérapie génique efficace chez lanimal |

|

|

| |

|

| |

Ataxie de Friedreich : une thérapie génique efficace chez l’animal

COMMUNIQUÉ | 07 AVRIL 2014 - 9H33 | PAR INSERM (SALLE DE PRESSE)

NEUROSCIENCES, SCIENCES COGNITIVES, NEUROLOGIE, PSYCHIATRIE

L’équipe d’Hélène Puccio, directrice de recherche Inserm à l’IGBMC (Inserm / CNRS / Université de Strasbourg), en collaboration avec celle de Patrick Aubourg (Inserm et Professeur de Neuropédiatrie à l’hôpital Bicêtre-Paris Sud) a démontré chez la souris, l’efficacité d’une thérapie génique sur l’atteinte cardiaque associée à l’ataxie de Friedreich, une maladie neurodégénérative rare héréditaire. Le transfert d’une copie normale du gène déficient dans la maladie, via un vecteur viral, a permis de guérir complètement et très rapidement le cœur malade des souris traitées. Ces résultats sont publiés le 06 Avril 2014 dans la revue Nature Medicine.

L’ataxie de Friedreich est une maladie héréditaire rare et grave, associant une atteinte neurodégénérative progressive, une atteinte du cœur et un risque accru de diabète. Cette pathologie concerne une naissance sur 50 000. Aucun traitement efficace n’est disponible à l’heure actuelle pour cette maladie. L’ataxie de Friedreich débute le plus souvent à l’adolescence par des troubles de l’équilibre et de coordination (ataxie) des mouvements volontaires des jambes et des bras, confinant la plupart des patients au fauteuil roulant au bout de 10 à 20 ans d’évolution. Ce sont cependant les complications cardiaques qui engagent le pronostic vital chez 60 % des patients, le plus souvent avant l’âge de 35 ans.

La maladie est causée par une mutation principale dans le gène FXN, qui conduit à une réduction drastique de la production de la protéine appelée « frataxine ». Le taux réduit de frataxine perturbe l’activité de la mitochondrie, un organite essentiel à la cellule et qui joue un rôle fondamental dans la production d’énergie. Les tissus nerveux (cervelet, moelle épinière) et cardiaque sont particulièrement touchés par ce déficit énergétique, qui peut provoquer jusqu’à une insuffisance cardiaque fatale.

Les équipes d’Hélène Puccio, directrice de recherche Inserm, et Patrick Aubourg ont développé une approche thérapeutique basée sur l’utilisation d’un virus adéno-associé (AAV)[1], qui est connu pour cibler et faire exprimer avec efficacité un gène thérapeutique dans les cellules cardiaques. Le virus a été modifié pour être rendu inoffensif, tout en gardant sa capacité d’introduire une copie normale du gène FXN dans les cellules du cœur et d’y faire ainsi exprimer la frataxine normale.

L’équipe d’Hélène Puccio a testé sur un modèle de souris reproduisant les symptômes cardiaques des patients atteints d’ataxie de Friedreich l’efficacité de ce traitement. Les résultats de l’étude démontrent qu’une seule injection d’AAVrh10 exprimant la frataxine par voie intraveineuse permet, non seulement d’empêcher le développement de l’atteinte cardiaque chez des animaux avant l’apparition des symptômes, mais de façon plus impressionnante, un rétablissement complet et rapide du cœur d’animaux à un stade avancé de la maladie cardiaque. Au bout de trois semaines de traitement, le cœur redevient totalement fonctionnel, l’aspect du tissu cardiaque et la fonction des mitochondries sont très proches de ceux de souris saines. « C’est la première fois qu’une thérapie génique permet une rémission complète, durable et aussi rapide d’une maladie cardiaque dans un modèle animal. » explique Hélène Puccio.

Mesure de l’activité d’une protéine mitochondriale (en bleu) essentielle à la production d’énergie cellulaire et qui est perturbée en absence de frataxine (absence de marquage dans le cœur non traité). Le traitement par thérapie génique exprimant la frataxine permet de corriger sur la totalité de la surface du cœur l’activité de cette protéine essentielle. © Inserm / H. Puccio

Par ailleurs, le système nerveux central étant une autre cible des vecteurs AAV, les équipes d’Hélène Puccio et Patrick Aubourg sont en train de vérifier si une approche similaire de thérapie génique pourrait être aussi efficace qu’elle l’est pour le cœur, au niveau de la moelle épinière et du cervelet.

Ces résultats prometteurs font d’ores et déjà l’objet d’un développement pour proposer aux patients atteints d’ataxie de Friedreich et une cardiomyopathie évolutive un traitement par thérapie génique. Dans cet objectif, trois des auteurs de la publication ont créé AAVLife, entreprise française dédiée à la thérapie génique pour les maladies rares, pour entreprendre les essais chez l’homme. Cet essai a fait l’objet d’une demande de dépôt de brevet par Inserm Transfert.

Cette étude a été réalisée notamment grâce au soutien des associations FARA[2], AFAF[3] et l’AFM[4].

[1] AAV : plus particulièrement le serotype AAVrh10.

[2] Friedreich’s Ataxia Research Alliance, association américaine dédiée au traitement de l’ataxie de Friedreich

[3] Association Française de l’Ataxie de Friedreich

[4] Association Française contre les Myopathies

DOCUMENT inserm LIEN |

| |

|

| |

|

|

|

La prise de décision implique une zone du cerveau jusqu'à présent méconnue |

|

|

| |

|

| |

La prise de décision implique une zone du cerveau jusqu'à présent méconnue

mardi 22 septembre 2015

Face à un changement dans notre environnement, il faut prendre des décisions adaptées. Et c'est le cortex préfrontal qui intervient en général. De manière inattendue, des scientifiques de l'Institut de neurosciences cognitives et intégratives d'Aquitaine (INCIA, CNRS/Université de Bordeaux) ont découvert qu'une zone du cerveau située dans le thalamus joue également un rôle capital dans la mise en œuvre de telles aptitudes évoluées. Menés chez le rat, ces travaux sont publiés le 23 septembre 2015 dans The Journal of Neuroscience.

Prendre des décisions adaptées en vue de subvenir à ses besoins est une nécessité pour tous les organismes vivants. En particulier, la capacité à prendre en compte les modifications soudaines dans l'environnement représente un enjeu important pour la survie des espèces. De telles prises de décision sont considérées comme des fonctions cognitives évoluées. Elles font intervenir le cortex préfrontal, une structure cérébrale parmi les plus développées et connue pour assurer les processus décisionnels.

L'équipe « Décision et adaptation » à l'INCIA s'est d'abord intéressée aux zones du cerveau connectées au cortex préfrontal. Par une technique de marquage, elle a mis en évidence une région particulière, le thalamus submédian, au rôle fonctionnel inconnu, qui est fortement connectée au cortex préfrontal.

Les scientifiques ont par la suite testé le rôle de ces deux structures cérébrales, thalamus submédian et cortex préfrontal, dans la prise de décision et l'adaptation à l'environnement. Pour cela, ils ont considéré trois groupes de rats : le premier présentant des lésions du cortex préfrontal, le deuxième au niveau du thalamus submédian, et le troisième regroupant des rats témoins sans lésion. Il s'agit de tester leur capacité à établir un lien entre un son et l'obtention d'une récompense alimentaire.

L'expérience s'est déroulée en deux étapes (voir schéma ci-dessous). La phase d'apprentissage d'abord a permis aux animaux d'apprendre que deux sons différents (S1 et S2) prédisent chacun la survenue d'une récompense alimentaire spécifique. Les trois groupes d'animaux visitent donc la mangeoire dès qu'un signal auditif est perçu. Les lésions n'empêchent pas les animaux d'apprendre qu'un stimulus auditif prédit l'obtention de la récompense. Lors de la deuxième étape, la procédure reste inchangée pour le premier son, mais pour le son S2, les chercheurs ont distribué des récompenses alimentaires durant et surtout en dehors des périodes sonores. Ce son perd donc sa valeur prédictive et un animal sans lésion en vient à négliger ce stimulus auditif S2 pour ne venir à la mangeoire que lorsqu'il entend le son S1. En revanche, les animaux présentant une lésion que ce soit au niveau du cortex préfrontal ou du thalamus submédian se montrent incapables de faire une telle distinction, et donc, de s'adapter.

Cette étude permet d'identifier l'existence d'un circuit entre le thalamus et le cortex qui s'avère primordial dans la prise de décision adaptée à l'environnement. L'originalité de cette découverte provient du rôle fondamental que les chercheurs attribuent au thalamus submédian, une structure jusqu'à présent ignorée dans le domaine des comportements adaptatifs. Ce résultat suggère que de nombreux circuits fonctionnels sous-tendant ce type de comportement impliqueraient une contribution du thalamus. Les chercheurs comptent poursuivre l'exploration de ces circuits « thalamocorticaux » dont la compréhension pourrait améliorer notre connaissance de nombreuses pathologies, comme la schizophrénie ou encore l'addiction.

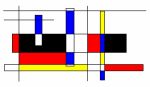

© Images obtenues au Bordeaux Imaging Center et réalisées par Fabien Alcaraz

Pour visualiser les voies nerveuses, deux marqueurs (rouge et vert) sont appliqués dans deux régions du cortex orbitofrontal. Ces molécules migrent ensuite pour s'accumuler dans les neurones thalamiques. Un marquage dense des deux traceurs est visible au niveau du thalamus submédian (délimité par des pointillés).

© Mathieu Wolff - équipe « Décision et adaptation » à l'INCIA (CNRS/Université de Bordeaux)

Téléchargez le communiqué de presse :

Références :

Flexible use of predictive cues beyond the orbitofrontal cortex: role of the submedius thalamic nucleus. Fabien Alcaraz, Alain R. Marchand, Elisa Vidal, Alexandre Guillou, Angélique Faugère, Etienne Coutureau, Mathieu Wolff. Journal of Neuroscience. 23 septembre 2015.

Contacts :

Chercheur CNRS l Mathieu Wolff l T +33 (0)5 57 57 95 07 l mathieu.wolff@u-bordeaux.fr

Presse CNRS l Priscilla Dacher l T +33 (0)1 44 96 46 06 l priscilla.dacher@cnrs-dir.fr

DOCUMENT CNRS LIEN |

| |

|

| |

|

|

|

Diabète de type 2 |

|

|

| |

|

| |

Diabète de type 2

Sous titre

Un trouble du métabolisme principalement lié au mode de vie

Le diabète correspond à un excès durable de la concentration de glucose dans le sang (hyperglycémie

hyperglycémie

Taux anormalement élevé de glucose (sucre) dans le sang.

). Dans le cas du diabète de type 2, ce phénomène est provoqué par une perturbation du métabolisme glucidique. Si elle apparaît progressivement et insidieusement, la maladie a des conséquences graves, voire mortelles, à long terme. Les diabétologues tentent de mieux comprendre les mécanismes impliqués pour la prévenir et traiter efficacement, tout en insistant sur l’importance du mode de vie dans sa survenue - et donc dans sa prévention - ainsi que sa prise en charge.

Dossier réalisé avec la collaboration de Rémy Burcelin (unité 1048 Inserm/Université Toulouse-3 Paul Sabatier, Institut des maladies métaboliques et cardiovasculaires (I2MC), équipe Facteurs de risque intestinaux, diabètes et dyslipidémies)

Comprendre le diabète de type 2

En France, la prévalence globale du diabète était estimée à 5% de la population en 2016, le diabète de type 2 (DT2) correspondant à 90% des cas. Ce chiffre est cependant largement sous-estimé puisqu’il ne tient pas compte des personnes non traitées ou non diagnostiquées. Or, compte tenu du caractère silencieux de la maladie, on estime que de 20 à 30% des adultes diabétiques ne sont pas diagnostiqués. Cette part diminue avec l’âge, tombant à 13 % chez les 55-74 ans.

L’incidence du DT2 augmente avec l’âge. La maladie se manifeste généralement après 40 ans et elle est diagnostiquée à un âge moyen proche de 65 ans. L’incidence est maximale entre 75 et 79 ans avec 20% des hommes et 14% des femmes traités pour cette maladie. Toutefois, le diabète de type 2 touche aussi de plus en plus de jeunes, y compris des adolescents, voire des enfants. C’est précisément la période durant laquelle s’acquièrent les habitudes alimentaires et celles relatives à la pratique d’une activité physique, deux leviers primordiaux dans la prévention de la maladie...

La prévalence

prévalence

Nombre de cas enregistrés à un temps T.

de la maladie a beaucoup augmenté ces dernières années. La tendance reste plus marquée dans certaines populations, notamment dans les départements d’Outre-mer et les départements ou les zones les moins favorisés d’un point de vue socio-économique. Une part de l’augmentation est liée au vieillissement de la population et à l’espérance de vie prolongée des diabétiques, mais elle tend à se stabiliser. En revanche, les déséquilibres nutritionnels et la sédentarité participent de plus en plus à la "propagation" du DT2. Cette hygiène de vie délétère, induisant une augmentation générale du poids et du nombre de personnes atteintes d'obésité, préoccupe au plus haut point les diabétologues. Autre sujet d’alerte : l’augmentation récente de diabètes "médicamenteux", associés en particulier à certains neuroleptiques

neuroleptiques

Médicaments utilisés pour combattre les troubles mentaux.

.

Une évolution lente et silencieuse

Le diabète de type 2 se développe silencieusement pendant de nombreuses années. L’hyperglycémie reste longtemps asymptomatique et la maladie est souvent découverte de façon fortuite à l’occasion d’une prise de sang, ou en cas de complication.

Cette hyperglycémie provient d’une baisse de sensibilité des cellules – en particulier celles du foie, du muscle et du tissu adipeux – à l’insuline. Cette hormone pancréatique a pour rôle de faciliter la pénétration du glucose (leur principal carburant) dans les cellules, ce qui en diminue la concentration sanguine. Pour répondre à la demande accrue en insuline découlant de cette insensibilité, les cellules insulinosécrétrices du pancréas en produisent davantage… jusqu'à s’épuiser. La production d’insuline devient alors insuffisante et le glucose s’accumule irrémédiablement dans le sang.

Qu’est-ce qu’une glycémie « normale » ?

La glycémie normale est d’environ 1 g/l à jeun. Elle varie au cours de la journée, augmentant en particulier durant plusieurs heures après les repas, d’où la nécessité de réaliser cette mesure à jeun le matin.

Au coeur des organes : La glycémie

Les complications du diabète

Le diabète entraîne des complications graves à long terme, pouvant survenir après 10 à 20 ans de déséquilibre glycémique. La maladie accélère en effet l’athérosclérose, à l’origine d’infarctus du myocarde, d’AVC ou d’artérites des membres inférieurs. En altérant également les microvaisseaux, le diabète est en outre à l’origine de rétinopathies (atteintes de la rétine entraînant un risque de déficience visuelle voire de cécité), de neuropathies périphériques, de néphropathies (insuffisances rénales), de maladies hépatiques (stéatose non alcoolique ou "maladie du foie gras") ou de problèmes de cicatrisation. Il peut aussi participer à une neurodégénérescence.

Les facteurs de risque : avant tout le mode de vie

Les études génétiques démontrent qu’il est extrêmement rare que le DT2 soit dû à la mutation d’un gène. En revanche, il existe sans doute des profils génétiques (i.e. des combinaisons de gènes) qui augmentent la susceptibilité à la maladie, autrement dit le risque de devenir diabétique si l’on adopte un mode de vie inadapté.

Mais le principal facteur de risque de DT2 tient à l’hygiène de vie. Une alimentation trop grasse et trop sucrée, combinée à la sédentarité (absence d’exercice physique), mène à l’obésité qui constitue en elle-même un facteur majeur de risque de diabète. Les enfants, via la surconsommation de sodas et autres boissons sucrés, ainsi que la disparition de la marche et des jeux au profit des loisirs sur écran, ne sont plus épargnés. Certains médicaments, en particulier des neuroleptiques, souvent prescrits en France, peuvent aussi participer au déclenchement d’un DT2.

D’autres facteurs interviennent, comme notamment la flore intestinale. Non seulement ce microbiote reflète le mode de vie (nutrition, médicaments, sédentarité) de son hôte, mais il peut lui-même constituer un facteur de risque et, dans certains cas, une cause directe de DT 2. On sait désormais identifier la "signature" d’un microbiote de patient diabétique. Des solutions thérapeutiques visant à traiter le microbiote plutôt que l’hôte pourraient émerger de ces connaissances.

Le diabète gestationnel

Il existe un risque accru de diabète chez les femmes enceinte : la grossesse peut en effet provoquer un diabète dit "gestationnel". Il survient généralement vers la fin du 2e trimestre et disparaît le plus souvent en fin de grossesse. Il peut cependant être révélateur d'un diabète préexistant non diagnostiqué. Dans ce cas, la maladie perdure après l'accouchement.

Pour en savoir plus sur la thématique Grossesse et diabète

Détecter et diagnostiquer

Les patients "prédiabétiques" (on parle aussi d’intolérance au glucose) ou même diabétiques ne présentent en général aucun signe clinique avant plusieurs années. De ce fait, l’âge moyen de prise en charge est souvent trop avancé (65 ans en France). L’hyperglycémie est alors déjà installée depuis longtemps et les dégâts ont commencé.

La seule méthode de détection de la maladie à un stade précoce est la mesure de la glycémie à jeun. Elle devrait être systématiquement effectuée chez les plus de 50 ans.

* Entre 1,10 et 1,26 g/l, le patient est considéré comme prédiabétique.

* Si la glycémie dépasse 1,27 g/l lors de deux dosages successifs, le diabète est déclaré.

D’autres critères – glycémie post prandiale, glycémie provoquée, taux d’hémoglobine glyquée (hémoglobine

hémoglobine

Protéine qui, associée au fer, permet le transport de l’oxygène dans les globules rouges.

sur laquelle s'est fixé du glucose) – peuvent confirmer ou préciser le diagnostic.

L’hygiène de vie, traitement prioritaire

Le traitement de référence du diabète de type 2, celui qui doit être entamé avant tout autre, est la modification des habitudes de vie, incluant :

* une perte de poids quand elle est nécessaire

* une activité physique régulière

* une alimentation équilibrée

Ces mesures peuvent être suffisantes pour contrôler la glycémie. Mais ces changements sont souvent difficiles à mettre en œuvre et à accepter par le patient.

Viennent ensuite des médicaments antidiabétiques, qui aident à contrôler la glycémie. Il existe plusieurs classes thérapeutiques fondées sur des mécanismes d’action différents, administrées seules ou associées entre elles. En première intention médicamenteuse, le praticien prescrit toujours de la metformine. En deuxième intention, et dans le cadre d’une approche de médecine personnalisée, il peut choisir entre de multiples options :

* Les sulfamides hypoglycémiants et les glinides stimulent la production d’insuline au niveau du pancréas.

* Les inhibiteurs des alpha-glucosidases retardent l’absorption des glucides après les repas.

* Les agonistesagonistesMolécule activant un récepteur en s'y fixant à la place du messager habituel

du récepteur du glucagon-like peptide-1 (GLP1) ralentissent la vidange gastrique, limitent l’appétit et stimulent la sécrétion d’insuline, mais uniquement en cas d’élévation de la glycémie. Ils limitent donc le risque d’hypoglycémie. Ils peuvent être combinés à une insuline dite "lente" qui maintient continuellement une concentration basale d’insuline.

* Des inhibiteurs DDP-4 bloquent la dégradation du GLP1,

* Les inhibiteurs de SGTL2, ou iSGTL2, agissent sur le rein en bloquant la réabsorption du glucose.

Il a été démontré que certains de ces traitements (agonistes du récepteur de GLP1, iSGLT2) ont en eux-mêmes des impacts positifs au niveau cardiovasculaire, hépatique ou rénal.

Malgré ces traitements, la glycémie de certains patients peut rester mal contrôlée. C'est en particulier le cas en l’absence d’amaigrissement, en cas d’impossibilité d’introduire une "vraie" activité physique, ou encore lorsque la capacité des cellules du pancréas à sécréter de l’insuline s’est épuisée au fil des années. Ces personnes ont alors recours à une insulinothérapie, qui consiste à s’injecter de l’insuline, comme dans le diabète de type 1. Il existe aujourd’hui une variété d’insulines "intelligentes", à action lente ou prolongée, qui permet d'adapter ce traitement à tous les cas. Associés à ces insulines, certains médicaments antidiabétiques comme les agonistes du récepteur à GLP1 peuvent en outre induire un amaigrissement notable.

Les enjeux de la recherche

La recherche sur le diabète de type 2 se poursuit selon deux grands axes :

* les mécanismes impliqués dans l’apparition de la maladie (recherche fondamentale), afin de découvrir de nouvelles cibles thérapeutiques

* le développement de solutions thérapeutiques (recherche préclinique et clinique).

Concernant le premier axe, les scientifiques s’attachent actuellement à décrypter les mécanismes moléculaires associés au rôle du microbiote intestinal dans la survenue du DT2. Quatre grands phénomènes sont explorés :

* les processus inflammatoires intestinaux

* la sécrétion et action des incrétines : GLP1 et et GIP (peptide insulinotrope dépendant du glucose), deux hormones gastro-intestinales stimulant la sécrétion d'insuline après les repas

* l’immunité intestinale

* le système nerveux entérique (axe intestin cerveau).

Cellules du pancréas endocrine de souris produisant de l’insuline (en vert) et du glucagon (en rouge). L’ADN des cellules est marqué en bleu. (Inserm/Annicotte, Jean-Sébastien)

Par ailleurs, il a été observé que les cellules adipeuses des patients obèses produisent des cytokines, molécules inflammatoires favorisant la résistance à l’insuline. Des équipes s’intéressent donc aux mécanismes responsables de l’induction de cette production de cytokines

cytokines

Substance synthétisée par certaines cellules du système immunitaire, agissant sur d'autres cellules immunitaires pour en réguler l'activité.

.

S'agissant du développement de nouvelles solutions thérapeutiques, les chercheurs développent des approches nutritionnelles destinées à rééquilibrer le microbiote des patients. Des essais cliniques sont également en cours pour évaluer l'intérêt de petites molécules de synthèse susceptibles d’influencer l’interaction microbiote/hôte.

A plus court terme, plusieurs nouveaux médicaments pourraient être mis sur le marché. Il s’agit de dual agonists, des molécules bi (ou tri) fonctionnelles. Ces peptides injectables agissent en effet simultanément sur deux, voire trois cibles, par exemple les récepteurs au GLP1, au GIP et au glucagon. Entre autres effets, ces molécules induisent une perte de poids très conséquente, de l’ordre de 10-15% en quelques mois.

DOCUMENT inserm LIEN |

| |

|

| |

|

| Page : [ 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 ] Précédente - Suivante |

|

|

| |

|

| |

|